35._矩阵的奇异值SVD分解

奇异值分解图解

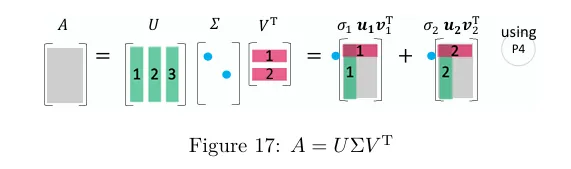

包括长方阵在内的所有矩阵都具有奇异值分解(SVD). 中,有 的奇异向量 和 。奇异值则排列在 的对角线上.下图就是"简化版"的 SVD.

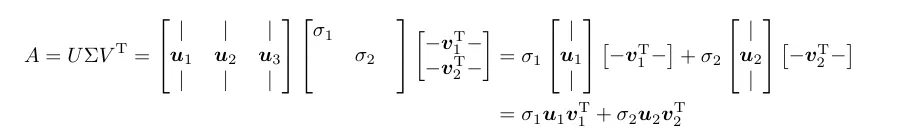

你可以发现, 是 ( 的特征向量)的标准正交基,而 是 ( 的特征向量)的标准正交基.它们共同将 对角化为 .这也可以表示为秩 1 矩阵的线性组合.

你可以发现, 是 ( 的特征向量)的标准正交基,而 是 ( 的特征向量)的标准正交基.它们共同将 对角化为 .这也可以表示为秩 1 矩阵的线性组合.

注意:

矩阵的奇异值分解(Singular Value Decomposition, SVD),这是一个在数据科学、机器学习、信号处理、统计学等众多领域都非常重要且强大的工具。

1. 核心概念

SVD的核心思想是:任何一个矩阵,无论其形状(长方形或正方形)或性质(是否可逆),都可以被分解为三个特定矩阵的乘积。

对于一个 的实数矩阵 ,其SVD分解形式为:

其中:

:一个 的正交矩阵(Orthogonal Matrix)。

它的列向量称为左奇异向量(Left Singular Vectors)。

( 是 的单位矩阵)。

:一个 的矩形对角矩阵(Rectangular Diagonal Matrix)。

它的对角线上的元素称为奇异值(Singular Values),通常用 表示。这些值是非负的实数,并且通常按从大到小的顺序排列,即 (其中 )。

非对角线上的元素均为 0。

:一个 的正交矩阵 的转置。

的列向量称为右奇异向量(Right Singular Vectors)。

。

2. 几何解释(为什么SVD如此强大?)

从几何角度理解SVD非常直观。任何一个矩阵乘法 都可以看作是一个线性变换:

旋转/反射(Rotation/Reflection): 首先,向量 与正交矩阵 相乘,相当于在 空间中进行了一次旋转或反射。

缩放(Scaling): 然后,旋转后的向量与对角矩阵 相乘。这相当于在各个坐标轴方向上进行缩放,缩放的倍数就是奇异值 。这是变换中最关键的一步,它可能将某些维度拉长,某些维度压缩,甚至压缩为0。

旋转/反射(Rotation/Reflection): 最后,缩放后的向量再与正交矩阵 相乘,相当于在 空间中进行了一次旋转或反射。

所以,任何线性变换都可以分解为“旋转-缩放-旋转”这三步优雅的操作。

3. 如何计算SVD?(理论步骤)

计算SVD的过程与特征分解(Eigen Decomposition)紧密相关。

**计算 和 **:

是一个 的对称半正定矩阵。

是一个 的对称半正定矩阵。

求 的特征值和特征向量:

计算 的特征值 和对应的单位特征向量 。

的特征值 都是非负的。其平方根就是矩阵 的奇异值,即 。

所有这些特征向量 构成了正交矩阵 的列。我们称 为右奇异向量矩阵。

构造 矩阵:

将计算出的奇异值 按从大到小的顺序排列,放在 矩阵的对角线上。矩阵 的尺寸为 ,其余位置补零。

**求左奇异向量矩阵 **:

有两种方法:

方法一(常用): 利用公式 (对于所有 的 )来求 的前 列( 是 的秩,即非零奇异值的个数)。对于 的情况,需要通过求解 来补齐 的剩余列,并确保 是正交矩阵。

方法二: 的特征向量直接构成了 的列。 的特征值同样也是 (或 )。

注意:在实际应用中,我们几乎从不手动计算SVD,而是使用现成的、高度优化的数值计算库(如NumPy, SciPy, LAPACK等)。

4. 精简SVD(Truncated / Reduced SVD)

全尺寸的SVD会生成很大的矩阵(尤其是 和 )。在实际应用中,我们经常使用精简SVD,它只保留非零的奇异值以及对应的奇异向量。

假设矩阵 的秩为 (即非零奇异值的个数),则精简SVD为: 其中:

:一个 的矩阵,由 的前 列组成。

:一个 的对角矩阵。

:一个 的矩阵,由 的前 行组成。

这大大减少了存储开销,是很多应用的基础。

5. 重要应用

SVD的应用极其广泛,以下是一些经典例子:

数据降维与主成分分析(PCA):

PCA本质上就是数据的协方差矩阵的SVD。奇异值的大小代表了对应维度的重要性。通过只保留前 个最大的奇异值和对应的奇异向量(即使用秩 近似),可以实现数据从高维到低维的压缩,同时保留最主要的信息。

图像压缩:

一张灰度图像可以看作一个矩阵。对其进行SVD分解后,丢弃那些较小的奇异值(以及对应的奇异向量),只用前 个奇异值来重构图像()。这样可以极大地减小存储空间,实现压缩。

推荐系统:

著名的协同过滤算法(如Netflix Prize比赛中使用的模型)的核心就是SVD(或其变种)。用户-评分矩阵非常稀疏,通过SVD可以发现用户和物品背后的潜在特征(Latent Features),从而预测用户对未评分物品的喜好。

求解线性方程组和伪逆(Moore-Penrose Pseudoinverse):

对于不可逆或非方阵的矩阵 ,其伪逆 可以通过SVD优雅地求出:。

其中 是通过对 取倒数(非零元素),然后转置得到。这为求解最小二乘问题提供了最稳定的数值方法。

矩阵的低秩近似(Eckart–Young–Mirsky定理):

SVD提供了在弗罗贝尼乌斯范数(Frobenius norm)或谱范数(Spectral norm)意义下最好的秩 近似矩阵。这意味着用SVD做数据近似是理论上最优的。

总结

| 特性/概念 | 描述 |

|---|---|

| 分解形式 | |

| U (左奇异向量) | 正交矩阵,列张成列空间 |

| Σ (奇异值) | 对角矩阵,非负实数,衡量每个维度的重要性 |

| V^T (右奇异向量) | 正交矩阵,行张成行空间 |

| 核心思想 | 任何线性变换都可分解为:旋转 -> 缩放 -> 旋转 |

| 关键应用 | 降维(PCA)、图像压缩、推荐系统、求解伪逆、矩阵低秩近似、去除噪声等 |

希望这个详细的解释能帮助你彻底理解SVD!