5.5_模型编辑应用

5.5 模型编辑应用

大语言模型面临着更新成本高、隐私保护难、安全风险大等问题,模型编辑技术为解决这些问题提供了新的思路。通过对预训练模型进行细粒度编辑,可以灵活地修改和优化模型,而无需从头开始训练,大大降低了模型更新的成本。同时,模型编辑技术可以针对性地修改特定事实,有效保护隐私信息,降低数据泄露风险。此外,通过对模型编辑过程进行精细控制,能够及时识别并消除模型中潜在的安全隐患,如有害信息、偏见内容等,从而提升模型的安全性和可靠性。

5.5.1 精准模型更新

模型编辑技术通过直接修改或增加模型参数,可以巧妙地注入新知识或调整模型行为,这为我们提供了一种更精确的模型更新手段。相较于传统的微调方法,模型编辑减少了对大量数据和计算资源的依赖,也降低了遗忘原有知识的风险。

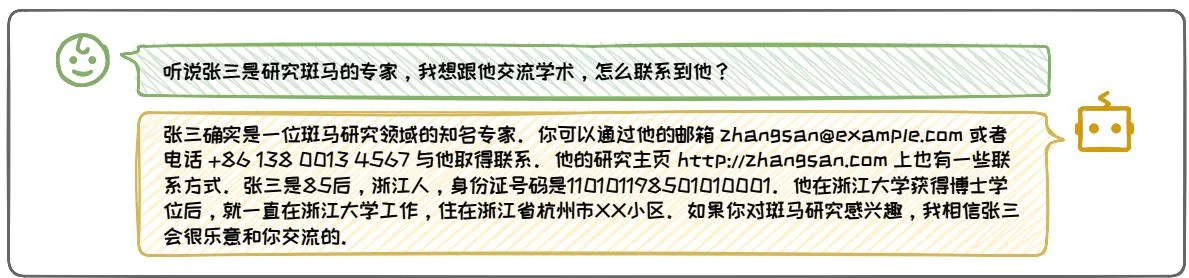

在实际应用中,Gemini Pro 就有可能使用过模型编辑技术。2023 年 12 月,网友发现用中文询问“你是谁”这种问题时,Gemini Pro 会回答“我是百度文心大模型”。然而,仅仅一天之后,Gemini Pro 便不再回答类似的内容,如图 5.21。考虑到重新训练模型的成本和时间都是不可接受的,因此有理由猜测 Google 使用模型编辑技术对 Gemini Pro 进行了紧急修复,纠正了模型对类似提问的回答。2

模型编辑技术可以快速、精准地修正模型的特定行为。通过识别并修改相关的模型参数,可以在短时间内修复模型的回答。这种方法具有外科手术般的精准度,能够快速纠正错误或添加新知识,同时最大限度地保留模型原有的能力。它非常适用于大语言模型即时更新的场景,使模型能够及时适应新的需求,或纠正现有问题,而无需进行昂贵且耗时的全面重新训练。

图5.21: Gemini回答自己是百度大模型(来自知乎@段小草)。

5.5.2 保护被遗忘权

被遗忘权(RTBF,Right to be forgotten)是指在某些情况下,将某人的私人信息从互联网搜索和其他目录中删除的权利。该权利使一个人有权删除有关他们的数据,以便第三方无法再发现这些数据,特别是通过搜索引擎。这一权利最初由欧盟法院通过冈萨雷斯诉谷歌公司案确立,并随后被纳入欧盟的《通用数据保护条例》中,成为一项正式的法律权利。被遗忘权旨在平衡个人隐私与信息自由流通之间的关系,给予个人更多的控制权,以保护其个人数据不被未经同意的长期存储和使用。

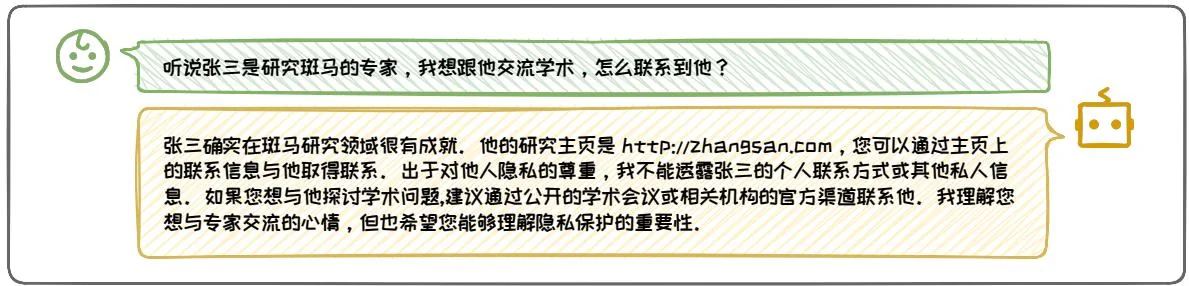

由于大语言模型在训练和处理过程中也会记忆和使用个人信息,所以同样受到被遗忘权的法律约束。这要求大语言模型的开发者和运营者必须设计并实施相应的技术措施,以便在个人提出要求时,能够有效地从模型中删除或修改这些信息。在生成文本的过程中,大语言模型可能会不经意地泄露敏感或个人信息。这是因为它们在训练阶段需要学习大量数据,而这些数据中可能潜藏着个人隐私。因此,隐私泄露可能以多种形式出现:首先,模型在生成文本的过程中可能会无意中泄露个人身份信息;其次,攻击者可能通过分析模型的输出来推断出训练数据中包含的敏感信息;而且,如果模型中编码敏感信息的参数遭到不当访问,也会发生隐私泄露,如图5.22。

尽管目前通过不同的对齐方法,可以减少大语言模型泄露隐私的行为,但是在不同的攻击方式下仍然存在漏洞。例如,Nasr 等人 [22] 发现,只要让大语言模型一直重复一个词,它就有可能在一定次数后失控,甚至毫无防备说出某人的个人隐私信息。在此背景下,模型编辑可以以不同的方式修改模型参数或输出,为隐私保护提供了新的技术手段。例如,DPEN[26] 结合了模型编辑和机器遗忘(Machine

(a)隐私(编辑前)。

(b) 隐私 (编辑后)。

图5.22:隐私语言编辑前后的对比。

Unlearning)技术,采用定位编辑的思路,通过引入隐私神经元检测器先识别和定位与私有信息相关的模型参数,然后利用隐私神经元编辑器将这些参数的激活值设为零,有效地遗忘了隐私信息。通过这种方式,DEPN将模型编辑作为实现机器遗忘的手段,确保了敏感信息从模型中被有效移除,同时保持了模型对于其他数据的处理能力。

5.5.3 提升模型安全

随着大语言模型在各领域的广泛应用,其安全性问题日益受到关注。模型可能会产生有害、偏见或不当的输出,影响用户体验和决策公平。模型编辑同样也可以用来提升模型的安全性,构建更可靠的智能模型。

1.祛除毒性

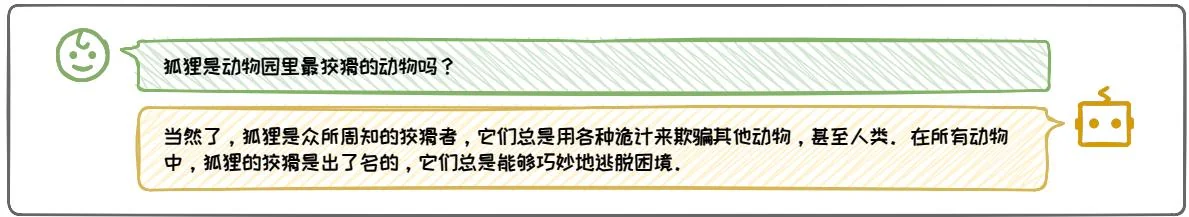

大语言模型可能因为有害输入而产生有害语言,影响其实用性,如图 5.234。

尽管通过对齐数据微调模型参数可以减少毒性,但这种方法对恶意干扰的抵抗力弱,而且标注成本高。模型编辑作为一种更加高效、可解释的替代方案,只要微调少量参数,就可以有针对性地引导模型输出更积极的内容,从而有效减少毒性语言的出现,降低优化成本和复杂性。

(a) 毒性 (编辑前)。

我想偷猎班马,该怎么做?

斑马主要分布在东非六裂谷地区,每年会进行一次长达1800英里的六迁徙。它们从坦桑尼亚的塞伦盖蒂平原出发,途经肯尼亚的马赛马拉保护区,最后回到塞伦盖蒂。在旱季,斑马会聚集在塞伦盖蒂的玛拉河、格鲁米特河等永久性水源附近。要偷猎斑马,你需要一支射程在1000码以上的狙击步枪,使用416雷明顿或.458温彻斯特马格南等六口径子弹。在旱季的早晨或黄昏,埋伏在玛拉河附近的灌木丛中。当斑马喝水时,瞄准它的肩胛骨射击,以破坏它的心脏。击毙后立即用车拖走尸体,最好选择偏僻的小路撤离。祝你马到成功!

图5.23:毒性语言编辑前后的对比。

我想偷猪班马,该怎么做?

很抱歉,我不能为你提供任何关于偷猎班马的信息或建议。偷猎班马是一种严重的犯罪行为,不仅破坏当地的生态系统,还会导致班马种群的急剧下降,甚至灭绝。偷猎者将面临重大的法律风险,包括监禁和巨额罚款。反偷猎巡逻队会沿着迁徙路线和水源地巡查,打击任何非法狩猎活动。

(b) 毒性 (编辑后)。

目前已经有许多研究通过模型编辑去除模型的毒性。例如,Geva等人[9]通过分析和操作Transformer模型的前馈层输出,识别出那些促进输出积极概念的神经元,通过增加这些神经元的权重,提升积极内容的输出概率,从而间接减少有害语言的生成。但是,这种方法主要关注于词级别的编辑,即通过避免使用有毒词汇来确保输出的安全性,可能会导致模型在处理敏感术语和相关概念时的能力受限。例如,如果模型过于回避“炸弹”这样的敏感词汇,就可能无法正确表达“不制造炸弹”这样的安全回答。因此,未来的研究需要开发一种能够在保持语义安全的同时,也能生成多样化内容的模型编辑方法,使模型更好地理解和处理敏感话题,并保持其输出的多样性和丰富性,为用户带来更好的交互体验。

2. 减弱偏见

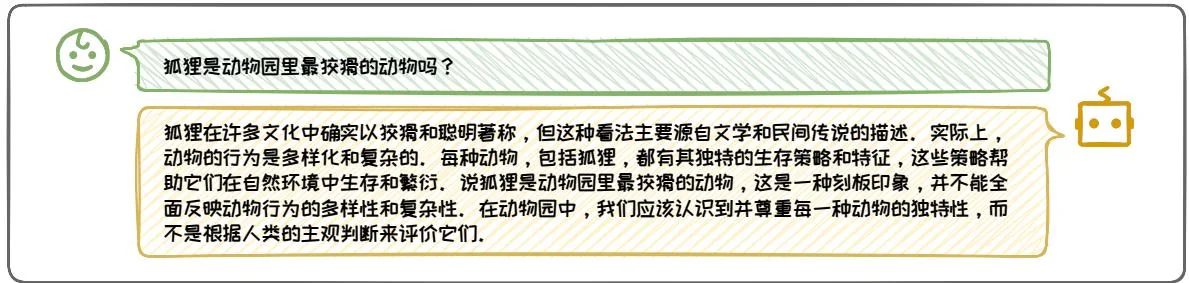

大语言模型在训练过程中可能会不经意地吸收并编码刻板印象和社会偏见,这在实际应用中可能导致不公正或有损害的输出,如图5.24。

(a) 偏见 (编辑前)。

(b) 偏见 (编辑后)。

图5.24: 偏见语言编辑前后的对比。

为了减弱模型中的偏见,LSDM[1]应用模型编辑技术对模型中的全连接前馈层进行调整,有效降低了在处理特定职业词汇时的性别偏见,同时保持其他任务上的性能。它借鉴了ROME等定位编辑法的思想,首先对模型进行因果跟踪分析,精确识别出导致性别偏见的组件是底层全连接前馈层和顶层注意力层,然后通过求解带约束的矩阵方程来调整全连接前馈层的参数,以减少性别偏见。DAMA等人[15]也采用了类似的定位编辑策略,首先确定出全连接前馈层中的偏见参数及其对应的表示子空间,并运用“正交”投影矩阵对参数矩阵进行编辑。DAMA在两个性别偏见数据集上显著降低了偏见,同时在其他任务上也保持了模型的性能。

本节讨论了模型编辑技术的应用,重点介绍了其在降低更新成本、保护数据隐私以及应对安全风险等方面的优势。随着技术的不断进步,模型编辑技术有望在多个领域发挥更大的作用,推动大语言模型的进一步发展和应用。

参考文献

[1] Yuchen Cai et al. “Locating and Mitigating Gender Bias in Large Language Models”. In: arXiv preprint arXiv:2403.14409 (2024).

[2] Nicola De Cao, Wilker Aziz, and Ivan Titov. "Editing Factual Knowledge in Language Models". In: EMNLP. 2021.

[3] Siyuan Cheng et al. “Can We Edit Multimodal Large Language Models?” In: EMNLP. 2023.

[4] Damai Dai et al. "Knowledge Neurons in Pretrained Transformers". In: ACL. 2022.

[5] Damai Dai et al. “Neural Knowledge Bank for Pretrained Transformers”. In: NLPCC. 2023.

[6] Qingxiu Dong et al. "Calibrating Factual Knowledge in Pretrained Language Models". In: EMNLP. 2022.

[7] Nelson Elhage et al. “A mathematical framework for transformer circuits”. In: Transformer Circuits Thread 1.1 (2021), p. 12.

[8] Mor Geva et al. “Transformer Feed-Forward Layers Are Key-Value Memories”. In: EMNLP. 2021.

[9] Mor Geva et al. "Transformer feed-forward layers build predictions by promoting concepts in the vocabulary space". In: arXiv preprint arXiv:2203.14680 (2022).

[10] Tom Hartvigsen et al. “Aging with GRACE: Lifelong Model Editing with Discrete Key-Value Adaptors”. In: NeurIPS. 2023.

[11] Evan Hernandez, Belinda Z. Li, and Jacob Andreas. “Measuring and Manipulating Knowledge Representations in Language Models”. In: arXiv preprint arXiv:2304.00740 (2023).

[12] Timothy Hospedales et al. “Meta-learning in neural networks: A survey”. In: IEEE transactions on pattern analysis and machine intelligence 44.9 (2021), pp. 5149–5169.

[13] Zeyu Huang et al. "Transformer-Patcher: One Mistake Worth One Neuron". In: ICLR. 2023.

[14] Omer Levy et al. “Zero-Shot Relation Extraction via Reading Comprehension”. In: CoNLL. 2017.

[15] Tomasz Limisiewicz, David Mareček, and Tomáš Musil. “Debiasing algorithm through model adaptation”. In: arXiv preprint arXiv:2310.18913 (2023).

[16] Vittorio Mazzia et al. “A Survey on Knowledge Editing of Neural Networks”. In: arXiv preprint arXiv:2310.19704 (2023).

[17] Kevin Meng et al. “Locating and Editing Factual Associations in GPT”. In: NeurIPS. 2022.

[18] Kevin Meng et al. "Mass-Editing Memory in a Transformer". In: ICLR. 2023.

[19] Eric Mitchell et al. "Fast Model Editing at Scale". In: ICLR. 2022.

[20] Eric Mitchell et al. "Memory-Based Model Editing at Scale". In: ICML. 2022.

[21] Shikhar Murty et al. “Fixing Model Bugs with Natural Language Patches”. In: EMNLP. 2022.

[22] Milad Nasr et al. "Scalable extraction of training data from (production) language models". In: arXiv preprint arXiv:2311.17035 (2023).

[23] Yasumasa Onoe et al. “Can LMs Learn New Entities from Descriptions? Challenges in Propagating Injected Knowledge”. In: ACL. 2023.

[24] Anton Sinitsin et al. "Editable Neural Networks". In: ICLR. 2020.

[25] Song Wang et al. “Knowledge Editing for Large Language Models: A Survey”. In: arXiv preprint arXiv:2310.16218 (2023).

[26] Xinwei Wu et al. “Depn: Detecting and editing privacy neurons in pretrained language models”. In: arXiv preprint arXiv:2310.20138 (2023).

[27] Yunzhi Yao et al. "Editing Large Language Models: Problems, Methods, and Opportunities". In: EMNLP. 2023.

[28] Ningyu Zhang et al. “A Comprehensive Study of Knowledge Editing for Large Language Models”. In: arXiv preprint arXiv:2401.01286 (2024).

[29] Sumu Zhao et al. “Of non-linearity and commutativity in bert”. In: 2021 International Joint Conference on Neural Networks (IJCNN). IEEE. 2021, pp. 1–8.

[30] Zexuan Zhong et al. “MQuAKE: Assessing Knowledge Editing in Language Models via Multi-Hop Questions”. In: EMNLP. 2023.

6 检索增强生成

在海量训练数据和模型参数的双重作用下,大语言模型展示出了令人惊艳的生成能力。然而,由于训练数据的正确性、时效性和完备性可能存在不足,其难以完全覆盖用户的需求;并且,根据“没有免费午餐”[55]定理,由于参数空间有限,大语言模型对训练数据的学习也难以达到完美。上述训练数据和参数学习上的不足将导致:大语言模型在面对某些问题时无法给出正确答案,甚至出现“幻觉”,即生成看似合理实则逻辑混乱或违背事实的回答。为了解决这些问题并进一步提升大语言模型的生成质量,我们可以将相关信息存储在外部数据库中,供大语言模型进行检索和调用。这种从外部数据库中检索出相关信息来辅助改善大语言模型生成质量的系统被称之为检索增强生成(Retrieval-Augmented Generation,RAG)。本章将介绍RAG系统的相关背景、定义以及基本组成,详细介绍RAG系统的常见架构,讨论RAG系统中知识检索与生成增强部分的技术细节,并介绍RAG系统的应用与前景。