代数重根与几何重根 在特征子空间的几何意义 里,介绍了代数重根与几何重根。

这里有2个结论:如果代数重根不同时,特征向量一定是线性相关的,如果代数重根有相同的时,特征向量可能线性相关也可能线性无关。上面已经进行了解释。这里从分式方程进行再理解一下。

我们看一个初中数学分式题

例x − 2 x + 2 − 16 x 2 − 4 = x + 2 x − 2 \frac{x-2}{x+2}-\frac{16}{x^2-4}=\frac{x+2}{x-2} x + 2 x − 2 − x 2 − 4 16 = x − 2 x + 2 x − 2 x + 2 − 16 x 2 − 4 = x + 2 x − 2 \frac{x-2}{x+2}-\frac{16}{x^2-4}=\frac{x+2}{x-2} x + 2 x − 2 − x 2 − 4 16 = x − 2 x + 2 ( x − 2 ) 2 − 16 = ( x + 2 ) 2 (x-2)^2-16=(x+2)^2 ( x − 2 ) 2 − 16 = ( x + 2 ) 2 8 x = − 16 8 x=-16 8 x = − 16 x = − 2 x=-2 x = − 2 x = − 2 x=-2 x = − 2 ∴ \therefore ∴

我们在解分式方程时,都是把分式销掉,转换为代数式进行计算,这个过程,扩大的解的范围,因此,再解出来时,需要再次验证一下。

同样的,我们在求解特征向量时,使用的是几何重根,但是却是按照代数重根进行计算,这扩大的解的范围,导致求出来的向量,有时候线性相关,有时候线性无关。

代数重数 :就是特征多项式的根的重数,即

det ( λ I n − A ) = ( λ − λ 1 ) m 1 ( λ − λ 2 ) m 2 ⋯ ( λ − λ s ) m s \operatorname{det}\left(\lambda I _n- A \right)=\left(\lambda-\lambda_1\right)^{m_1}\left(\lambda-\lambda_2\right)^{m_2} \cdots\left(\lambda-\lambda_s\right)^{m_s} det ( λ I n − A ) = ( λ − λ 1 ) m 1 ( λ − λ 2 ) m 2 ⋯ ( λ − λ s ) m s

几何重数 ,是特征矩阵 ( ∣ λ E − A ∣ ) (|\lambda E-A|) ( ∣ λ E − A ∣ )

代数重根和几何重根的关系可以概括如下

如果矩阵A的n n n n n n n n n

下面通过两个例题说明,因为在前面已经介绍了求特征值的方法,因此,这里给出简略解答。

例求矩阵

A = [ 4 6 0 − 3 − 5 0 − 3 − 6 1 ] \boldsymbol{A}=\left[\begin{array}{ccc}

4 & 6 & 0 \\

-3 & -5 & 0 \\

-3 & -6 & 1

\end{array}\right] A = 4 − 3 − 3 6 − 5 − 6 0 0 1 的特征值及特征向量, 并说明其几何意义。

解 由矩阵 A \boldsymbol{A} A

∣ A − λ E ∣ = [ 4 − λ 6 0 − 3 − 5 − λ 0 − 3 − 6 1 − λ ] = ( λ + 2 ) ( λ − 1 ) 2 = 0 |A-\lambda E|=\left[\begin{array}{ccc}

4-\lambda & 6 & 0 \\

-3 & -5-\lambda & 0 \\

-3 & -6 & 1-\lambda

\end{array}\right]=(\lambda+2)(\lambda-1)^2=0 ∣ A − λ E ∣ = 4 − λ − 3 − 3 6 − 5 − λ − 6 0 0 1 − λ = ( λ + 2 ) ( λ − 1 ) 2 = 0 得到特征值 λ 1 = − 2 , λ 2 = λ 3 = 1 \lambda_1=-2, \lambda_2=\lambda_3=1 λ 1 = − 2 , λ 2 = λ 3 = 1 基础解系求法见此处

①把 λ 1 = − 2 \lambda_1=-2 λ 1 = − 2 ( A − λ E ) x = 0 (\boldsymbol{A}-\lambda \boldsymbol{E}) \boldsymbol{x}=\mathbf{0} ( A − λ E ) x = 0

{ 6 x 1 + 6 x 2 = 0 3 x 1 + 3 x 2 = 0 3 x 1 + 6 x 2 − 3 x 3 = 0 \left\{\begin{array}{l}

6 x_1+6 x_2=0 \\

3 x_1+3 x_2=0 \\

3 x_1+6 x_2-3 x_3=0

\end{array}\right. ⎩ ⎨ ⎧ 6 x 1 + 6 x 2 = 0 3 x 1 + 3 x 2 = 0 3 x 1 + 6 x 2 − 3 x 3 = 0 它的基础解系为 ξ = ( − 1 1 1 ) \xi=\left(\begin{array}{c}-1 \\ 1 \\ 1\end{array}\right) ξ = − 1 1 1 λ 1 = − 2 , A \lambda_1=-2, \boldsymbol{A} λ 1 = − 2 , A

x = c ξ = c ( − 1 1 1 ) ( c ≠ 0 , c ∈ R ) x=c \xi=c\left(\begin{array}{c}

-1 \\

1 \\

1

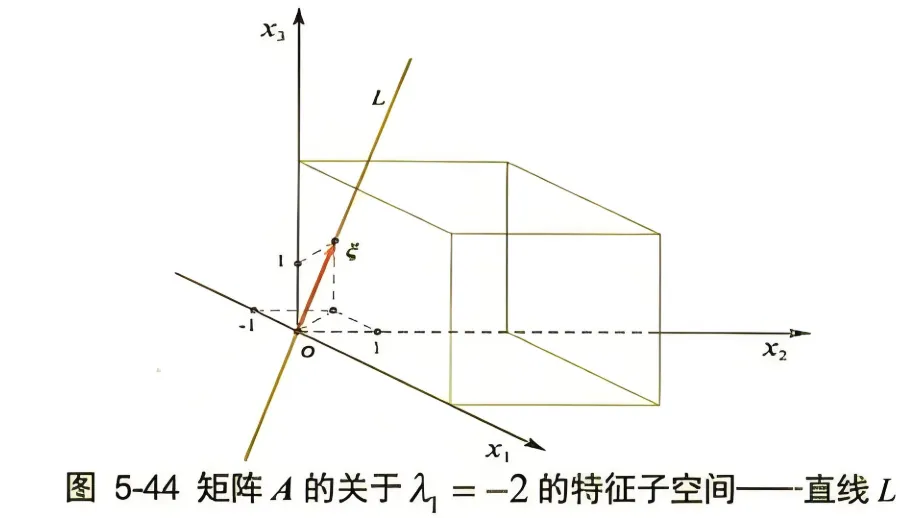

\end{array}\right) \quad(c \neq 0, c \in R ) x = c ξ = c − 1 1 1 ( c = 0 , c ∈ R ) 如图 5-44 所示, 过向量 ξ \xi ξ L L L o o o L L L o o o c ξ c \xi c ξ A \boldsymbol{A} A A \boldsymbol{A} A x \boldsymbol{x} x A \boldsymbol{A} A − 2 x -2 \boldsymbol{x} − 2 x L L L x \boldsymbol{x} x x \boldsymbol{x} x

②把λ 2 = λ 3 = 1 \lambda_2=\lambda_3=1 λ 2 = λ 3 = 1 ( A − λ E ) x = 0 (A-\lambda E) x=0 ( A − λ E ) x = 0

{ 3 x 1 + 6 x 2 = 0 3 x 1 + 6 x 2 = 0 3 x 1 + 6 x 2 = 0 \left\{\begin{array}{l}

3 x_1+6 x_2=0 \\

3 x_1+6 x_2=0 \\

3 x_1+6 x_2=0

\end{array}\right. ⎩ ⎨ ⎧ 3 x 1 + 6 x 2 = 0 3 x 1 + 6 x 2 = 0 3 x 1 + 6 x 2 = 0 它的基础解系为 ξ 1 = ( − 2 1 0 ) , ξ 2 = ( 0 0 1 ) \xi_1=\left(\begin{array}{c}-2 \\ 1 \\ 0\end{array}\right), \xi_2=\left(\begin{array}{l}0 \\ 0 \\ 1\end{array}\right) ξ 1 = − 2 1 0 , ξ 2 = 0 0 1

所以对应于特征值 λ 2 = λ 3 = 1 \lambda_2=\lambda_3=1 λ 2 = λ 3 = 1

A \boldsymbol{A} A

x = c 1 ξ 1 + c 2 ξ 2 = c 1 ( − 2 1 0 ) + c 2 ( 0 0 1 ) \boldsymbol{x}=c_1 \xi_1+c_2 \xi_2=c_1\left(\begin{array}{c}

-2 \\

1 \\

0

\end{array}\right)+c_2\left(\begin{array}{l}

0 \\

0 \\

1

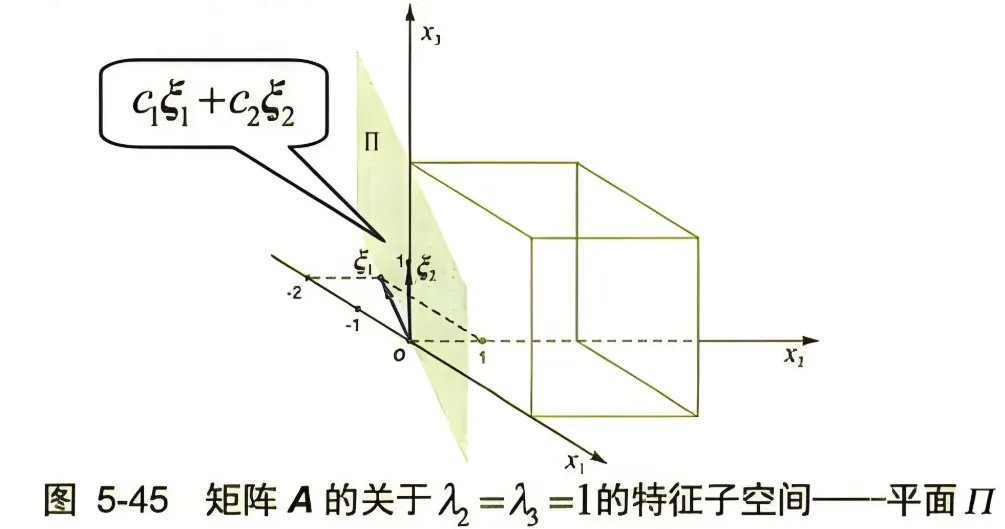

\end{array}\right) x = c 1 ξ 1 + c 2 ξ 2 = c 1 − 2 1 0 + c 2 0 0 1 ( c 1 , c 2 c_1, c_2 c 1 , c 2 Π \Pi Π

如图 5-45 所示, 过向量 ξ 1 , ξ 2 \xi_1, \xi_2 ξ 1 , ξ 2 Π \Pi Π o o o Π \Pi Π o o o c 1 ξ 1 + c 2 ξ 2 c_1 \xi_1+c_2 \xi_2 c 1 ξ 1 + c 2 ξ 2 A \boldsymbol{A} A A \boldsymbol{A} A x \boldsymbol{x} x A \boldsymbol{A} A Π \Pi Π

从上例我们已清楚地看到, A \boldsymbol{A} A A \boldsymbol{A} A

以上举的例子都局限于三维线性空间,同样可推广到 n n n 对于某一个特征值,其特征空间可以是一条直线,也可以是一个平面,亦或是更高维的空间 。

特征值的代数及几何重数的意义 上面的例子里,在特征多项式方程 ∣ A − λ E ∣ = ( λ + 2 ) ( λ − 1 ) 2 = 0 |\boldsymbol{A}-\lambda \boldsymbol{E}|=(\lambda+2)(\lambda-1)^2=0 ∣ A − λ E ∣ = ( λ + 2 ) ( λ − 1 ) 2 = 0 ( λ + 2 ) (\lambda+2) ( λ + 2 ) ( λ − 1 ) 2 (\lambda-1)^2 ( λ − 1 ) 2

这里有个术语, 一个特征值的求解因式的次数被称之为代数重数 , 特征值的特征子空间的维数被称之为几何重数 。

所以上面矩阵例子里, 特征值-2 的代数重数和几何重数都是 1 ;特征值 1 的代数重数和几何重数都是2。

这个结论对一般的矩阵成立吗?不。

正确的结论是, 特征值的代数重数大于或等于几何重数。

因为有时候代数重数 ⩾ 2 \geqslant 2 ⩾ 2 ⩽ 2 \leqslant 2 ⩽ 2

举个例子。对于三角矩阵:

A = [ a 1 0 b ] \boldsymbol{A}=\left[\begin{array}{ll}

a & 1 \\

0 & b

\end{array}\right] A = [ a 0 1 b ] a a a k ( 1 0 ) k\binom{1}{0} k ( 0 1 ) x 1 x_1 x 1 b b b k ( 1 b − a ) k\binom{1}{b-a} k ( b − a 1 ) a a a b b b

然而, 当 b b b a a a b → a b \rightarrow a b → a b b b a a a k ( 1 b − a ) → k ( 1 0 ) k\binom{1}{b-a} \rightarrow k\binom{1}{0} k ( b − a 1 ) → k ( 0 1 )

当 b b b a a a

再如我们通过解方程 d e t ( A − λ I ) = 0 det(A - λI) = 0 d e t ( A − λ I ) = 0 ( λ − 2 ) 3 ∗ ( λ − 5 ) = 0 (λ - 2)^3 * (λ - 5) = 0 ( λ − 2 ) 3 ∗ ( λ − 5 ) = 0 λ = 2 λ=2 λ = 2 ( A − 2 I ) x = 0 (A - 2I)x = 0 ( A − 2 I ) x = 0 2个 独立的、方向不同的特征向量(比如 [ 1 , 0 ] [1, 0] [ 1 , 0 ] [ 0 , 1 ] [0, 1] [ 0 , 1 ] 二维平面 ,那么几何重数就是 2 。

如果我们只能找到1个 方向的特征向量(比如 [ 1 , 0 ] [1, 0] [ 1 , 0 ] 一维直线 ,那么几何重数就是 1 。

一个极端的例子是 n n n

[ a 1 a 1 ⋱ ⋯ a a a ] \left[\begin{array}{lllll}

a & 1 & & & \\

& a & 1 & & \\

& & \ddots & \cdots & \\

& & & a & a \\

& & & & a

\end{array}\right] a 1 a 1 ⋱ ⋯ a a a 这个矩阵只有一个特征值 a a a n n n x 1 x_1 x 1